DAW上における音楽制作、マスタリング時において重要なディザリング(Dithering)についての解説。ただし、小難しい説明はなるべくせずに、ミュージシャンでも納得できるような記事にしています。

ディザリングはデジタルでの音楽制作においては不可欠な処理であり、必ず行ってください!!

目次 :

ディザリングとは何か?

ハイレゾ・フォーマットでの音楽制作が当然になった昨今において、ディザリングはとても重要です。なぜなら、製作者が意図したサウンドをリスナーに出来る限り正確に伝えるための技術だからです。

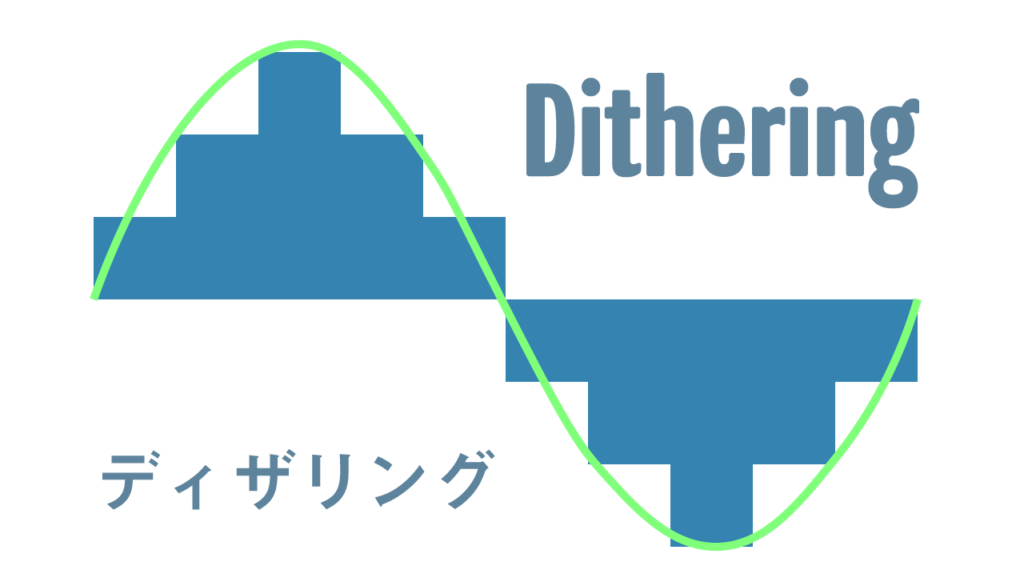

ディザリングとは簡単に言うと、

デジタル処理、変換における劣化を緩和するためにノイズ(乱数)を音に加える

ということです。

高解像度のデジタルデータをそれよりも低い解像度に変換する際のデータの欠落、劣化を緩和するための処理で、少数点以下の数字を四捨五入する代わりにノイズを加える、という処置です。

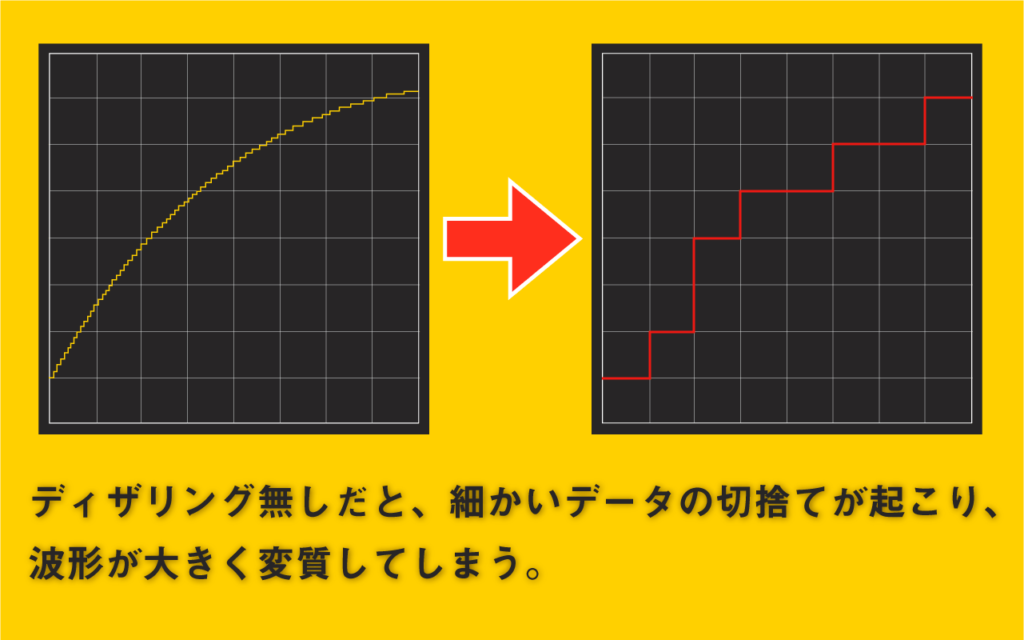

DAW上で制作した高品質オーディオデータを低い解像度に変換する以上、データの劣化は避けられません。しかし、上の図のようなあまりに変わり果ててしまうような変化を防ごう!というのがディザリングです。

以上の説明に関して、二つの疑問が出てきます。まずは、デジタルは0と1で構成されており、劣化などしないのではないのか、ということと、音にノイズを加えていいのか?ということです。

これらについては、デジタルでも劣化はあるし、音にノイズを加えるのは、そのデメリットよりメリットが上回っている、とだけここでは書きます。詳しくは後で解説していきます。

ディザリングは一度だけ

ディザリングとは、あえてノイズを加えることと言いました。ミックスやDTMでの実践で重要なのは、ディザリングは一回だけやればいい、ということです。何回もディザリングをしてしまうと、それだけノイズが増えて、音質が落ちてしまいます。

単なるミックスダウンの段階では、MIXと同じ高解像度のオーディオファイルを出力すればいいので、ディザーは必要ありません。

DAW内部の解像度が32bitや64bitなら、32bitのオーディオファイルを出力すればいいです。その32bitを16bitに変換する、マスタリングの時、一回のみにディザリングは必要になります。MP3などの圧縮音源に変換する際も当然ディザーを加えますが、高解像度マスターから直接変換すればいいです。

いくつかマスタリング用のプラグインには、ディザー機能が付いている場合があります。もし、これを使う場合は、DAW側のディザーはOFFにする必要があります。でないと、二重にディザーが掛けられることになってしまいます。

ディザーは音に限らない

ディザリングの一般論的な説明については、wikipediaのディザーの記事が詳しいです。ここでは飛行機内における機械式計算機を例として取り上げています。機械に振動を与えるという点では、調子の悪いアナログテレビを叩いて直す、というのもディザリングになります。

上記のwikipediaの記事の冒頭を引用。

ディザ(Dither)とは、量子化誤差(端数)を、単純に丸めるのではなく、全体の量子化誤差が最小化するよう確率を調整して切り捨てまたは切り上げのどちらかをランダムにおこなうためによるゆらぎのことである。

この説明では、なかなか分かりにくいですよね。これでナルホド!と理解できる人はほとんどいないと思います。音楽のディザリングにも触れていますが、こちらも分かりにくいです。

しかし、画像処理については実際に画像を使って説明しているので、そこはイメージを持ちやすいはずです。本記事では、もう少し分かりやすい説明を目指していきます。

つまりディザリングとは、あらゆるデジタル処理におけるデータの変質を最小限に抑える技術であり、音に限らないということです。

デジタルは『変わらない』のか?

デジタル・オーディオが普及しはじめて30年ほど経ちましたが、デジタル技術への誤解が様々な迷信を生みました。特に音は目に見えないので、そうした傾向はオーディオにおいて顕著です。

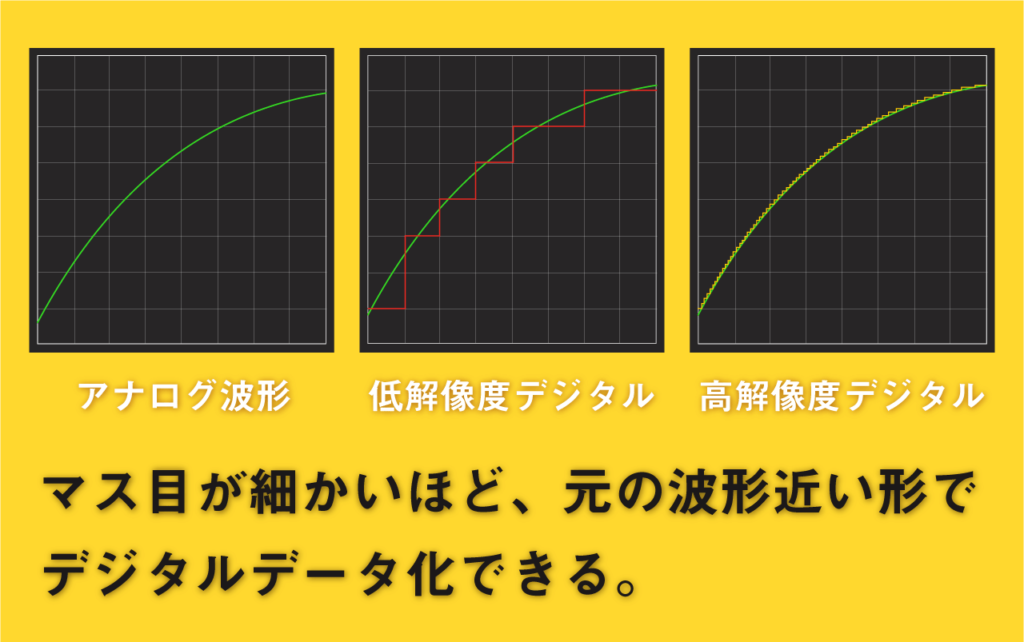

上の図のように、同じアナログデータをデジタル化しようとしても、解像度が低いと赤線のようにガクガクのデジタルデータになります。しかし、図示されているマス目以上の細かい高い解像度(マス目は省略しています。)でデジタル化すれば、右の図の黄色線のように元の波形に近い・デジタルデータを得られます。(赤線よりは細かいギザギザ。)つまり、デジタルといえども変わります。

その変化にどこまで有意差があるかはまた別の話。マス目が細かくなるほどデータ量は増加し、処理も重たくなるので、音質とデータ量のバランスの良いマス目で落ち着きます。(デジタル技術の進化とともに大きくなってきました。)

デジタルが変わらないというのは、主に記録保存の面であり、正しく保存されていれば、データは変化せず、そういう意味で音は変わらないです。逆にアナログテープへの記録はどうしても経年劣化しますので、常に変化し続けていると言えます。

しかし、データが壊れてしまったり、なんらかの理由で変質してしまった場合は、音も変わりますし、データ補正技術はありますが、それにも限界がありますし、デジタル的な意味では決して同一とは言えません。

また、データは同じだとしても、音楽については、そのデジタルデータ(0と1の集合体)を、電気信号というアナログ信号に変換する必要があります。

その変換をする電子部品をD/Aコンバータ(デジタル/アナログ変換機)といいますが、その性能(電気信号への変換精度)によって、最終的な音は当然変わります。これは、同じ文章でも朗読する人の声や上手さで受ける感動が違う、と例えられるかも知れません。

なので、デジタルは変わらない、というのは正しい部分もあるし、そうではない部分もあるということです。

DAWからCD, MP3へ | ビット、ハイレゾ

現在では、パソコンを使い音楽制作しますが、DAW(”DAWとは何か?”参照)と呼ばれる統合制作ソフトを使います。

多くのDAWでは制作の際の音楽のフォーマットを選択できます。bit深度とサンプルレートです。これらは大きければ大きいほど、音の精度、音質が上がりますが、同時により高い処理能力が求められるので、コンピュータに負担がかかります。

そうした、より大きなbitとサンプルレートでの作業は、CDの音質を超えたハイレゾ環境、音質になります。

実はレコード産業とは、アナログ時代からスタジオで制作されたハイレゾなマスター音源を公式に劣化コピーし、そのコピーを消費者に売る、というビジネスです。(英語圏では、本やCDなどの出版物はそのまま“Copy”と呼ばれます。)

要はデジタル技術というのは、アナログなもの、自然界にあるモノ、現象を数字に置き換えることで、コンピュータ上で記録したり、処理したり、シミュレートするための技術です。その精度は取り扱う数の規模、フォーマットによって決まります。

ビットとは?

Bit(ビット)直接的にはコンピュータ上で扱う数の桁数になりますが、要するに数の範囲、規模になります。桁数が大きければ大きいほど、より大きな数を扱えるし、より精確になります。音楽制作においては、32bitが標準となっています。

数字の話はあまりしたくないですが、bitは全て2の倍数でビット数が乗数になります。つまり、8bitなら2の8乗で256だし、16bitなら2の16乗で65536です。bit数が増えるほど扱える数の規模は爆発的に増えていきます。 学校の一学年程度の人数なら8bitでも十分でしょうが、広い場所で人数を数えるには16bit以上ないと数が足りません。

とりあえず、大きいほど音質が良くなるという理解で大丈夫です。

サンプルレートとは?

サンプリングすることで、アナログデータをデジタルに変換するわけですが、そのサンプリングをする頻度、回数を意味します。一秒間にどれだけサンプリングするか、という数字になっています。これもやはり、大きければ大きいほど良いですが、大きすぎてもコンピュータへの負担、デジタルエラーの原因になったります。

制作においては、出来得る限りハイレゾの方がいいです。しかし、最終的には、そうしたハイレゾ・マスター音源をCDやMP3などのフォーマットへ変換する必要があります。CDは16bit 44.1kHzというフォーマットで、MP3はそこからさらに圧縮したフォーマットになります。

マスター音源から、CD音源(16bit 44.1kHz)に変換するにしろ、MP3などの圧縮音源に変換するにしろ、必ずディザリングを行わないといけません。またMP3にする際は、マスターから直接MP3に変換するべきでCD音質にする必要はありません。

何の下処理もせずに単純に変換すると、デジタル劣化、デジタル歪みが発生します。デジタルであっても、信号の劣化は起こるのです。

デジタル歪みとは何か?

デジタルはクリーンなんだ!歪むわけない!という方がいるかもしれません。しかし、ビットクラッシャーというエフェクターは、デジタル歪みを人工的に起こして、音を過激に変化させるものです。

あのような変化が32bit >>> 16bitというビット変換でも起きるわけです。演出としてならいいですが、通常この場面での音質変化というのは望まれない変化です。取り除くか軽減させる必要があります。

デジタルフォーマットというのは、いわばマス目の細かさです。

現実とは無限に分割でき、隙間がありません。そして、そこで起きる物理現象も無限に分割できる絶え間ない現象です。音はまず電気信号に変換されますが、電気信号もまた自然の物理現象の一つです。

しかし、コンピュータには能力の限界があり、分割するのに限りがあります。

それでも、コンピュータ上で、出来る限りリアルな再現をするには出来る限り、細かいマス目でアナログデータをデジタル化する必要性があります。

それがbit深度であり、サンプルレートになります。これらが大きいほど、マス目は細かくなり、デジタル化された波形とオリジナルのアナログ波形は出来る限り近づくことになります。

問題はデジタルからデジタルへの変換です。細かいマス目から大きなマス目への変換、つまり高い解像度から低い解像度に変換するときに、どうしてもずれてしまいます。なぜなら、大きなマス目で捉えることのできない、こまかい数は切り捨てられて、波形が元の波形と比べて、ずれてしまうからです。コレが歪みであり、音の再生の観点からすると、忠実度が失われたということです。

歪みを最小限に。ディザリングの意義

結論から言えば、こうしたデジタル歪みはなくすことは出来ません。大きな器に入った水を小さな器の水に映しても大部分は流れ落ちてしまうことに似ています。

しかし、デジタルオーディオにおいてはなるべく元の波形からかけ離れすぎないように歪みを抑える、テクニックがあります。それがディザリングです。

ノイズを加えることで、デジタル処理にランダム性を与え、歪みを緩和する技術になります。ノイズ、ということは騒音と思われがちですが、ハイレゾでの制作の場合、加える不快なノイズというわけではありません。

ノイズといっても・・・

様々なDAWにノイズ発生機能があるので、分かると思いますが、主なノイズ音、ホワイトノイズやピンクノイズは必ずしも聞くに堪えない音ではありません。アナログテレビの音のザーっという類の音です。

特にピンクノイズは自然界にも存在する音で、滝の落ちる音などになります。ランダム性もあいまって、いくらでも聴いていられます。ディザーで加えられるノイズというのは、その種のものなので、確かに余計な音が混入はしますが、デジタル歪みよりはマシな音なので安心してください。

そして、元々の音源がハイ・ビットであるほど、加えるノイズの音量は相対的に小さくて済みます。なので、32bitで制作された音源であれば、ほとんど聞き取ることのできない音量にできます。

ディザリングで音は変わる?

pow-rという加えるノイズを人間の聴覚に基づいて加工して、目立たせなくする技術もあります。それによって、結果的に音源の聴こえ方が変わる、というのはあるようです。しかし、そこまで絶対的な変化ではないので、普通はそこまで気にすることではないと考えられます。

DAWによっては、ディザーの種類を自分で切り替えられるものもありますが、通常はデフォルトのディザーで問題ないです。

最初からハイレゾ音源なら?

デジタルからデジタルに変換すると音が変化してしまうというのなら、ハイレゾのままリスナー渡してしまえばいい、そうすればミュージシャンやエンジニアがスタジオで聴いていた音に近い音を楽しめる!

というのは最近巷で話題のハイレゾ音源の持つ意義になります。なので、ハイレゾ音源というのは音を良くしているのではなく、本来の音に近いから良い、ということです。

そういう意味では、CDはもはや必要ないのかもしれません。しかし、CDのような低レゾ・圧縮メディアが存在する以上、ディザリングは必要不可欠な処理になります。

まとめ!

というわけで、出来る限り分かりやすく、シンプルにディザリングについての解説をまとめてみました。最終的な理解をするためには、コンピュータや情報処理についての詳しい理解が必要になるのだろうと思いますが、音楽制作においては、本記事に書かれている内容で十分です。